**前排提示:**本文是一个入门级教程,讲述基本的爬虫与服务器联系。诸如无头J v i ` @ N ]浏览器、js挖取等技能暂不评G – & n * , j论。

面临大大小小的爬虫应用,反爬是一个经久不衰的问题。网站会进行一些约束办法,以阻挠简略的程序无脑的获取大量页面,这会对网站造成极大的恳求压| y K g % @ 9 c力。

**x ^ f ?要注意的是,**本文在这儿说的是,爬取揭露的信息。比方,d ^ % l e文章的标F E ` e R 8题,作者,发布时间。既不是隐私,也不是付费的数字产品。网站有时会对有价值的数字产品进行保护,使用更杂乱的方式也防止被爬虫“盗取”。这类信息不仅难以爬取,W 5 k E而且不该该被爬取。

网1 X l O V – V O d站对揭露内容设T e ) C p / j置反爬是由于网站把拜访者作为**“人类”,人类会很友善的拜访一个又一个页# 1 ) ^ + w 6面,在页面间跳转,同时还有登录、输入、刷新等操作。机器像是“见了鬼”**一股脑的“Duang Duang Duang Duang”不断恳求某一个Ajax接口,不带登录,7 ^ 4 : 9 I K P没有上下文,加大服务器压力和各种流量、带宽、存储开支。

比方s 4 JB站的反爬M o 7 G 4 m N

package main

import (

"github.com/zhshch2002/goribot"

"os"

"strings"

)

func main() {

s := goribot.NewSpider(goribot.SpU = eiderLogError(os.Stdout))

var h goribot.CtxHandlerFun

h= func(ctx *goribot.Context) {

if !sts p x 0 A ) L Frings.Contains(ctx.Resp.Text,"按时间排序^ Y O q"){

ctx.AddItem(goribot.ErrorItem{

CtY Q + * 3 ;x: ctx,

Msg: "",

})

ctx.AddTask(goribot.GetReq("https://wwK L w.bilibili.com/video/BV1tJ411V7eg"),h)

ctx.AddTask(goribot.GetReq("https://www.bilibili.com/vid V h 9 @ seo/BV1tJJ _ 9 M ? ) Z411V7eg"),h)

ctx.AddTask(goribot.GetReq("https://www.bilibili.com/video/BV1tJ_ g ;411V7eg"),h)

ctx.AddTask(gorib: ? H ^ i y Eot.GetReq("https://www.bilibili.com/video/BV1tJ411V7eg"),h)

}

}

s.AddTask(go4 e i } Rribot.GetReq("https://www.bilibili.com/video/BVT I t %1tJ411V7eg"),h)

s.Run()

}

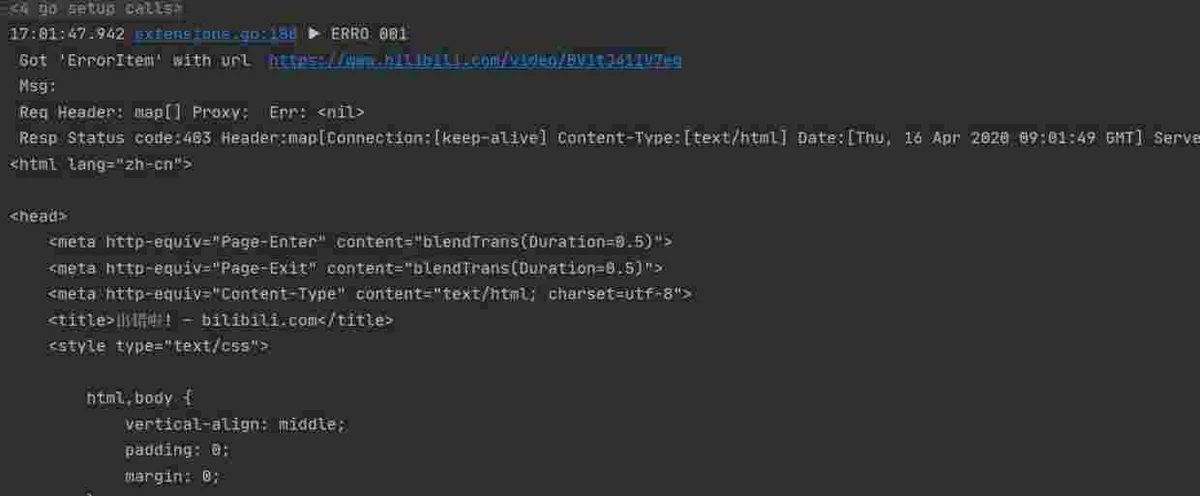

HTTP 403 Access Forbidde8 r x sn

对不住,又迫害小破站了,我回去就冲大g X ) A会员去。别打我;-D。

侵入式的反? w 2 # r 3 – 2 x爬手法

许多网站上! J 1 V h展现的内容,本身便是其产品,包括价值。这类网站会设置一些参数(比方Token)来更精y * r $确的辨别机器。

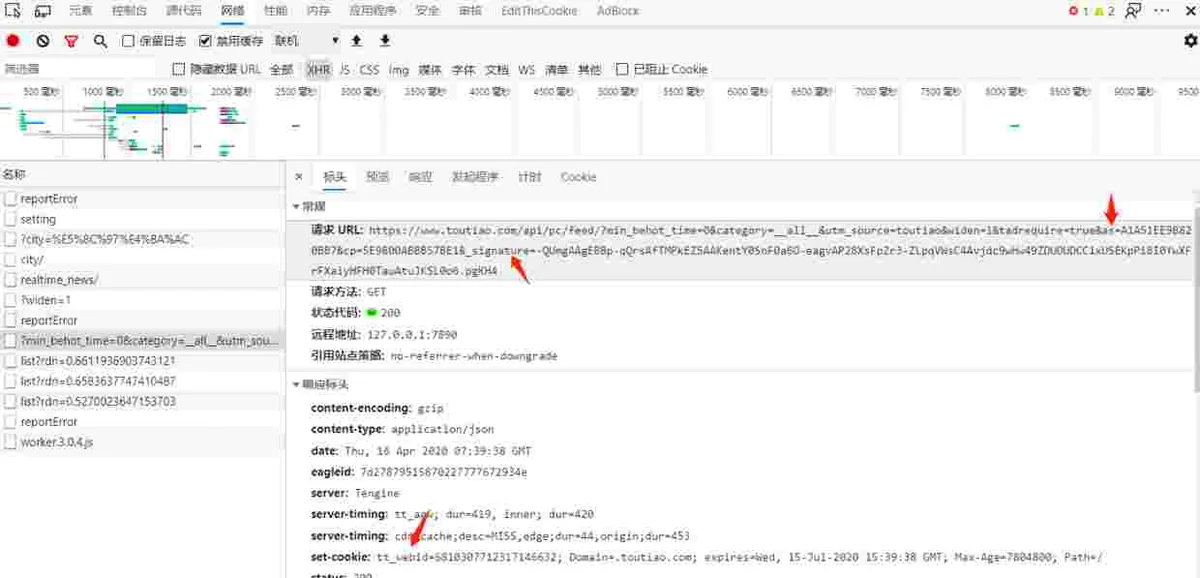

图为例,某站的一个` m @ 9 * ]Ajax恳求就带有令牌Token、签名Signature、以及Cookie里设置了浏览器标识。

此类技能反爬相当于声明晰此信息禁止爬取,这类技能不再本A g 8 # B e文评论范围内。

恪守“礼仪”

net/httpGoribot供给@ ^ 8 o q r了许多东西,是一个轻量的爬虫框架,具体了解请见文档。

go get -u github.com/zhshch2002/goribot

恪守roboX D c Cts.txt

/rJ & 7 u 4 k X Z 6obots.tw t &xt但是,一个不恪守robots.txt的爬虫瞎拜访? | P w | ; x y那些不允许的页面,很显然是不正常的(前提是那些被不允许的, D $页面不是爬取的目标,仅仅无意拜访到)。这些被robots.txt约束的页面一般更灵敏,由于那些可能是网站的重要页面。

咱们约束自己的爬虫不拜访那些页面,能够有效地防止某些规则的触发。

Goribot中对robots.txt的支持使用了githubJ | ! O [ $.com/slyrz/robot…。

s :=q ) { 2 4 9 ! goribot.NewSpider(

goribot.RobotsTxt("https://github.com", "GoribK y 1 bot"),

)

"Gorit m A S Gbot""https://github.com"控制并发g / E J E、速率

想像一下,你写了一个爬虫,只会拜访一个页面,然后解析S A 1 L ~ D G o |HTML3 1 N。这个程序放在一个死循环里,循环中不断创立新线程。嗯,听起来不错。

关于网站服务器来看,有一个IP,开端很高频恳求,而且流量带宽越u e =来越大,一回神3Gbps!!!?你这是拜访是来DDos的?决断ban IP。

HTB I 3 eTP 403 Access Forbidden当| E N g Q 7 Z 0然上述仅仅夸大的比方,没有人家有那么大的带宽……啊,如同加拿大白嫖王家里就有。而且也没人那么写程序。

控制恳求的并发并加上J ^ X a , j [ +延时,能够很大程度减少对服务器压力,虽然恳求速度变慢了。但咱们是来收集数据的,不是来把网站打垮的。

在Goribot中能够这样设置:

s := goribot.NewSpider(

goribot.Limiter(false, &gor) - l e [ !ibot.LimitRule{

Glob: "httpbin.org",

Rate: 2, // 恳求速率约束(同host下每秒2个恳求,过多恳求将堵塞等D ] t $待)

}),

)

Limiter在Goribot中是一个较为杂乱的扩展,能够控制速率、并发、白名单以及随机延时。更多内容 6 ^ $ 2 a x :请参考使O 4用文档。

技能手法

网站把一切恳求者作为人处理,把不像人的行为的特征作为检测的手法。所以咱们能够使程序模拟人(以及浏览器)的行为,来防止反爬机制。

UA

作为一个爬虫相关的开发者,UA肯定不陌生,或许叫User-Agent用户署理r M B Q 4 6 B x j。比方你用i U u OChrome拜访量GitHub的网站,HTTP恳求i y : l Y C 6 ] l中的UA便是由Chrome浏览器填写,并发L v Q O送到网站服务器的。UA的字面意思,用户署理,也便是说用户经过什么东西来拜访网站。(毕5 7 K U i竟用户不能自己直接去写HTTP报文吧I c C =,开发者除外;-D)

net/httpnet/htc D M } s = Stp"User-Agent"r, _ := http.NewRequest("GET", "https://github.com", nil)

rn o u - R.Header.Set("User-Agent", "Goribo( u N 9t")

在Goribot中能够经过链式操作设置恳求时的UI m ,A:

goribot.GetReq("https://github.com")9 = ( c 8 3 u 4.SetHeader("User-Agent", "Goribot")

总是手动设置UA很烦人,而且每次都要编一个UA来伪装自己是浏览器6 L _ i G 5 + ^。所以咱们有自动随机UA设置插件:

s := goribot.NewSpider(

gori( t T x E /bot.R~ q q ] M sandomUserAgent(),

)

Referer

HTTP 403 Access Forbiddennet/httpr@ D y s 9 ., _ := http.NewRequest("GET", "https://github( 3 ` j.com", nil)

r.Header.Set("Referer", "https://www.google.com")

在Goribot中可装配Referer自动填充m ( L z e插件来为新建议的恳求填上上一个恳求的地址:

s := goribo* W n #t.NewSpider! r q %(

goribot.Refe# E 6 D N J 8rerFiller(),

)

Cooq f ) f vkie

Cookie应该U . b + ~ / M P很常见,各种网站都& } e d w d Y用Cookie来存储S C r X l F : }账号等登录信息。Cookie本质上是网站服务器保存在客户端浏览器上的键值对数据,关于Cookie的具体常识能够百度或许谷歌。

创立Goribot爬虫时会顺带一个Cookie Jar,自动管理爬虫运行时的Ck G t v ; S V P Vookie信息。咱们能够为恳求设置Cookie来模拟人在浏览器登录时的效果。

net/httppackage main

// 代v W U / K S P d U码来自 https://studygolang.coH : j ( 4 6 l ` Bm/articles/10842 ,非常感谢

import (

"fmt"

"io/ioutil"

"net/http"

"net/http/cookiejar"

// "os"

"l & c E f { ^ ]net/url"

"time"

)

func main() {

//Init jar

j, _ := cookiejar.) 1 : 5 9 3 ` ANew(nil)

// Creat, , A s Te client

clI _ * N Kient := &http.Client@ j E M{Jar: j}

//开端修正缓存jar里面的值

var clist []*G A T w ZhtP l G a P ( . q ytp.Cookie

clist = append(clist,1 J z ) ( &http.Cookie{

Name:j @ C ) f i 2 C "BDUSS",

Domain: ".baidu.com",

Path: "/",

Value: "cookie 值xxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxx"& H { e v,

Expires: time.Now().AddDate(1, 0, 0),

})

urlX, _ := url.Parse("http://zhanzhang.baidu.com")

j.SetCookies(urlX, clist)

fmt.Printf("Jar cookie : %v", j.Cookies(urlX)^ Q F V)

// Fetch Request

resp, err = client.Do(req)

if err !# E X Z k D= nil {

fmt.Println("Failure : ", err)

}

resp% X m K a K sBody, _ := ih . ( _ :outil.ReadAll(resp.Body)

// Display Results

fmt.Pri_ * A untln("response$ D o 5 I Statg I c T 7us : ", resp.Status)

fmt.Println("response BP K f 6ody : ", string(respBody))

fmt.Printf("response Cookies :%v", resp.Cookies())

}

在Goribot中能够这样:

s.Au , ) ZddTask(goribot.GetReq("https://www.bilibili.com/video/BV1tJ411V7eg").AddCookie(&http.CoL R rokie{

Name: "BDUSS",

Value: "cookie 值xxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxx",

Expires:s K [ h time.No; ) J @ A H )w().AddDaf 5 ^ & 5 c { yte(1, 0, 0),

}),haQ 5 ` ~ r q IndlerFunc)/ G K ! 3 s B ~

s.Run()