你能自动写高并发程序吗? 实际上,很多时候幻觉都发生在这里。

果朗并发真的比java高吗?高并发 java golang。

使用了两种语言,但没有开发相同的业务。 然而,在目前的业务下,GO性能已经得到了具体的测试,而不会太担心GO性能,据说即将到来的GO1、5将再次提高性能太多。 其实还是很喜欢GO语言,简单,实用,并且适合大规模并发。 围棋学习阈值低于java。 如果担心gc影响实时,也可以申请大量内存做自己的内存管理。golang百万并发。

也许JavaGC更好,去不够。

去并发比较好,Java达到同样效果,回调写死。

真的很想知道,只是考验自己。 一个自我设计的测试更有可能反映你想要的指标。

事实上,他们的差异应该足够小,不能被考虑。

golang百万级高并发实例:如何用go语言每分钟处理100万个请求

恶意软件我们经历了显著的增长,自从我一年前加入硅谷公司以来,一个主要的责任变成了设计架构和开发系统,以支持一个快速增长的信息安全公司和所有所需的设施,以支持数百万用户每天使用的产品。 我在反病毒和反恶意软件行业的不同公司工作了12年,所以我知道这些系统有多复杂,因为我们每天都处理大量的数据。

有趣的是,在过去的9年左右,我所参与的所有网络后端开发通常都是通过Ruby on Rails技术完成的。 别怪我。 我喜欢Ruby on Rails,我相信这是一个令人惊讶的环境。但过了一段时间,您将开始以红宝石般的方式思考和设计系统,如果您能够利用多线程、并行、快速执行和小内存开销,您将忘记软件体系结构应该是多么高效和简单。 多年来,我是一个c/c、Delphi和c#开发人员,我刚刚开始意识到使用正确的工具可以使复杂的事情变得更容易。

作为首席架构师,我不会非常关心互联网上的语言和框架战争。 我相信效率,生产力。 代码可维护性主要取决于如何简单地设计解决方案。 由于在我们的匿名遥测和分析系统中工作,我们的目标是能够处理来自百万级终端的大量POST请求。 Web处理服务可以接收JSON数据,其中包含需要写入AmazonS3的许多有效负载的集合。 接下来,地图接收系统可以操作数据。按照惯例,我们研究服务层次结构,涉及以下软件:golang高并发。

Sidekiq

延迟的工作

兔子MQ

等等。

构建两个不同的集群,一个提供web前端,另一个提供后端处理,这样我们可以横向扩展后端服务的数量。golang rpc高并发。

但是从一开始,我们的团队就知道我们应该使用Go,因为我们看到这可能会成为一个非常大的(大流量)系统。 我使用Go语言大约2年了,我们开发了几个系统,但很少实现这样的负载(负载量)。golang高并发底层原理。

我们开始创建从POST调用定义Web请求负载的结构,以及上传到S3budket的函数。

键入struct{golang 高并发服务器。

字符串`json:“版本”`

令牌字符串`json:“令牌”`golang在高并发的优势。

有效载荷[]有效载荷`json:“数据”,`类型为有效载荷结构{golang http 高并发。

//[编辑]Func(p*有效负载)上传到S3//[编辑]Func错误{

该方法确保没有名称冲突

如果我们在密钥名称中得到相同的时间戳golang高并发解决方案。

storage_path:=fmt。 Sprintf(“%v/%v”,p。,时间。 现在()。 Unix Nano())golang 高并发框架。

桶:=S3Bucketgolang socket 并发。

b:=新的(字节。 缓冲)

编码Err:=json。 新编码器(B)。 编码(有效载荷)golang实例。

如果编码Err! =零{golang嵌入实例。

返回编码Err//我们发送到S3Bucket的任何东西都应该标记为“私有‘golang 并发。

瓦尔ACL=S3、 私人

变量内容类型=应用程序/八集流“”

返回桶。 输入阅读器(storage_path,b,int64(b。len(),内容类型,acl,s3、 选项{})本地Go例程方法。我们从一个非常本地化的POST处理实现开始,只是尝试将发送到简单Go例程的作业并行化:golang并发原理。

func(w http。r*http。request){

如果r。方法! =贴“{golang 并发设计模式。

W。写标题(http。

将主体返回/读取到字符串中,用于json解码

变量内容=&{}golang并发编程。

呃:=约翰逊。 新解码器(IO。 极限阅读器(r。身体,最大长度))。 解码(&内容)

如果错误! =零{golang 并发下载。

头()。 集合(“Content-Type”,“application/json;charset=UT F-8”)

W。写标题(http。

返回/执行每个有效载荷和队列项,单独张贴到S3

对于_,有效载荷:=范围内容。 有效载荷{

去有效载荷。 上传到S3()/<;-不要这么做。 写标题(http。 状态OK)对于中小型负载,这将对大多数人有效,但在大规模上,该方案很快将被证明不能很好地工作。 我们期望的请求数量,而不是我们刚刚开始计划的数量级,当我们将第一个版本部署到生产环境中时。 我们完全低估了流量。 以上方案很多地方都很差。 没有办法控制我们生产的GO例程的数量。 当我们每分钟收到100万个POST请求时,代码很快就崩溃了。 再试一次我们需要找到一种不同的方法。 正如我们从一开始就讨论过的,我们需要保持请求处理程序的生命周期短,并且保持后台生成的进程。 当然,在ruby on rails world中,这也是你必须做的,否则,无论你是使用美洲狮、UNI CORE还是乘客,你、UNI CORE还是乘客(我们不要谈论jruby)。 然后我们需要使用常见的处理方案来实现这一点,例如resque、sidekiq、SQS等。 这个列表将继续保留,因为有很多解决方案可以做到这一点。 在第二次迭代中,我们创建了一个缓冲区通道,可以对作业进行队列并将它们上传到S3、 因为我们可以控制队列中的最大项数,所以我们有很多内存来安排作业。 我们认为我们只需要缓冲频道中的工作。

var Que Chan Payload

函数init(){golang并发模型。

Que=make(chan Payload,MAX_QUE)func(w http。,r*http。请求){/通过每个有效载荷和队列项,单独张贴到S3

对于_,有效载荷:=范围内容。 有效负载{队列<;-有效负载。接下来,我们从队列中获取作业并处理它们。 我们使用类似于以下的代码:func(){for{选择{case作业:=<;-队列:<;-仍然不好}老实说,我不知道我们在想什么。 一定是一夜红牛。 这种方法没有带来太大的改进。 我们使用有缺陷的缓冲区队列并发,只是为了延迟问题。 我们的同步处理器只同时上传一个数据到S3,因为传入的请求远远大于单个核心处理器上传到S3的能力。 我们的缓冲通道很快达到它的极限,然后阻塞请求处理逻辑队列中更多项的能力。 我们刚刚避免了这个问题,开始了我们系统的倒计时。 当部署有缺陷的版本时,我们的延迟以每分钟不变的速度增长。 最好的解决方案我们讨论了在使用GO通道时如何使用公共模式创建二级通道系统,一种是排队作业,另一种是控制使用多少工人同时操作作业队列。 想法是,以恒定的速率并行上传到S3不会导致机器崩溃或导致连接错误到S3、 所以我们选择了创造一种工作/工人模式。对于那些熟悉Java、C++和其他语言的开发人员来说,我们可以将这种模式看作是使用通道以golang的方式实现工作线程池的一种替代。

var(golang 并发容器。

马克斯工人=操作系统。 Getenv(“MAX_工人”)

最大队列=操作系统。 Getenv(“MAX_QUE”)/Job表示要运行的作业

键入Jobstruct{golang 并发控制。

有效负载/缓冲通道,我们可以发送工作请求。golang分布式 并发。

瓦罗布·奎尔·陈·乔布

//工人代表执行工作的工人

类型工人结构{

工人PoolchanChanJob

工作频道陈乔布

退出陈伯芬新工人(工人池陈工)工人{。返回工人{

工人游泳池:工人游泳池,

工作频道:制作(陈乔布),

退出:make(Chanbool}/Start方法启动工人的运行循环,列出退出通道

万一我们得阻止它

功能(W工人)开始(){

去Func(){

将当前工人注册到工人队列中。

工人游泳池-W。工作频道

选择{

个案工作:=<;-w。工作频道:

我们收到了一份工作要求。

如果错误:=;错误! =零{

日志。 错误f(“加载到S3:%s的错误”,错误。 错误())

我们收到了停止的信号

返回}()停止指示工人停止侦听工作请求。

功能(W工人)停止(){

去Func(){

w。quit-true}

我们已经修改了我们的Web请求处理程序,使用有效负载创建一个Job实例并将其发送到JobQue通道,以便于访问。

func(w http。r*http。request){

如果r。方法! =贴“{

W。写标题(http。

将主体返回/读取到字符串中,用于json解码

变量内容=&{}

呃:=约翰逊。 新解码器(IO。 极限阅读器(r。身体,最大长度))。 解码(&内容)

如果错误! =零{

头()。 集合(“Content-Type”,“application/json;charset=UT F-8”)

W。写标题(http。

返回/执行每个有效载荷和队列项,单独张贴到S3

对于_,有效载荷:=范围内容。 有效载荷{

让我们用有效载荷创建一个作业

工作:=作业{有效载荷:有效载荷}

把工作推到队列上。

工作队列-工作。 写标题(http。 状态OK)。当web服务器初始化后,我们创建Dispatcher,然后调用Run()函数创建工作人员池,开始监听job。 在工作队列中。

调度员:=(MaxWorker)

调度员。 快跑()

下面是Dispatcher实现代码:。键入Dispatcherstruct{

//在调度员注册的工人通道池

工人PoolchanChanJobfunc(最大工人int)*Dispatcher{

池:=制作(陈陈乔布,最大工人)

返回&Dispatcher{WorkerPool:pool}func(d*Dispatcher)运行(){

//开始工作的人数

对于I:=0;iD。max工人;i{

工人:=新工人(游泳池)

工人。 开始()去d。调度()func(d*Dispatcher)调度(){

选择{

个案工作:=-乔布队列:

//已收到工作请求

去Func(作业){

//尝试获得可用的工人工作通道。

//这将阻塞直到工人空闲

工作频道:=-D。工人游泳池

//将工作调度到工人工作通道

工作频道-工作

}(工作)}。请注意,我们提供初始化并添加到池中的最大工作人员数。 由于这个项目我们利用了Amazon的DockerGo环境,我们经常遵循12因素方法在生成环境中配置系统,并且我们从环境变化中读取这些值。 这样,我们就可以控制工人的数量和作业队列的大小,这样我们就可以在不重新部署集群的情况下快速更改这些值。

var(

马克斯工人=操作系统。 格腾夫(“MAX_WORKERS“)

最大队列=操作系统。 格腾夫(“MAX_QUE”)直接结果

当我们部署时,我们立即看到延迟下降到一个小值,而处理请求的能力没有太大的提高。

在弹性负载均衡器完全启动后,我们看到应用程序每分钟提供100万个请求。 通常早上有几个小时的时间,流量峰值每分钟超过一百万次。

一旦我们部署了新代码,服务器数量就从100台急剧下降到20台左右。在合理配置集群和自动平衡配置以及弹性自动缩放设置为xEC2c4之后,我们可以将服务器数量减少到4个实例。 大型新实例,如果CPU在5分钟内达到90%的利用率。 在我的书中,简单总是获胜。 我们可以使用多队列、后台工作人员、复杂的部署来设计一个复杂的系统,但我们决定使用Go语言的自动缩放功能和开箱即用功能来简化并发。

我们只使用了4台机器,这不是新的。 也许他们不像我一样像MacBook,但他们每分钟处理100万个写到S3的请求。

有正确的工具来处理问题。 当您的Ruby on Rails系统需要更强大的Web处理程序时,请考虑Ruby生态系统之外的技术,也许可以获得更简单但更强大的替代方案。

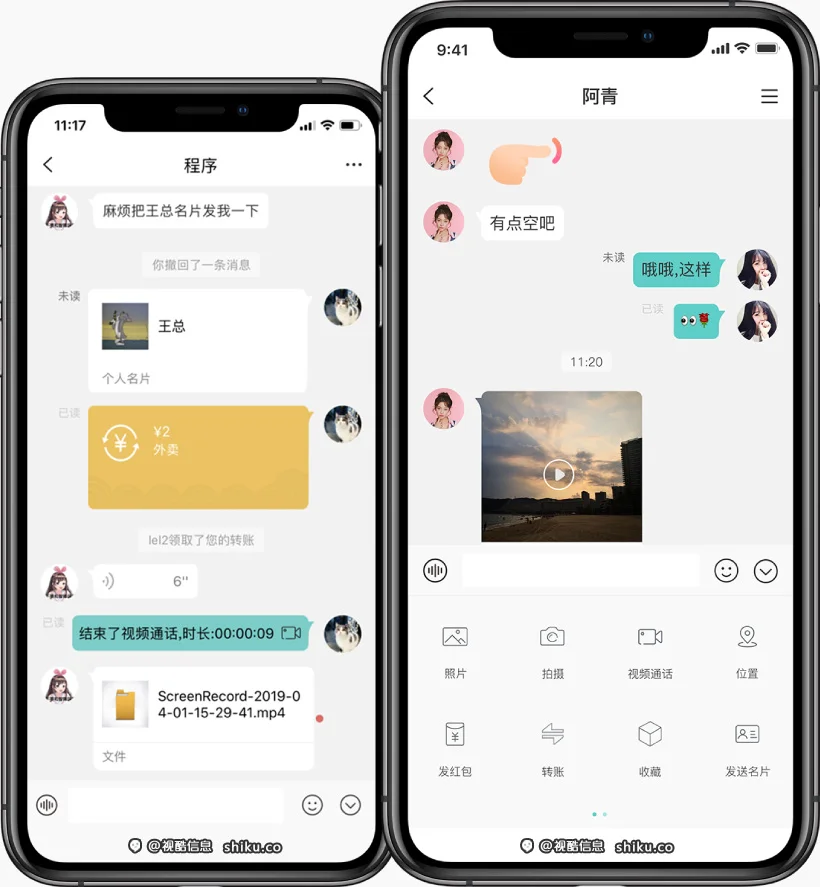

本文原创出自视酷IM团队机器人,如有任何问题,请联系视酷官方客服www.shiku.co